La secuencia es siempre más o menos la misma: sucede algo novedoso pero no tanto, algo en el límite del verosímil, un límite muy lábil últimamente. Algunas personas se sorprenden (porque sin sorpresa, no hay noticia). Se sorprenden y lo comparten, y durante un ratito tomamos lo compartido como cierto; como (¡allá lejísimo!) la imagen de la campera blanca del Papa por ejemplo. O, antes, y con herramientas quizás más toscas, en ciertos “virales” de YouTube que se revelaban en horas o días como experimentos de determinada agencia de publicidad. La palabra “experimento” sale mucho en estos casos, quizás porque conlleve un cierto deslinde de responsabilidad: no hay mala intención, solo estaba probando, viendo qué tan lejos podía llegar mi inventiva, tu ingenuidad. Algo así debe haber dicho Orson Welles aquella vez que asustó a medio Estados Unidos con una invasión extraterrestre contada por radio en tiempo real, con el disclaimer de que había avisado que era ficción. Ficción, qué concepto.

Esta vez le tocó el turno a la academia (bueno, tampoco es la primera vez). El título Hipnocracia fue mencionado en el AI Action Summit de Cannes, un foro de discusión del impacto de la IA a nivel europeo, por Gianluca Misuraca, director científico de la iniciativa europea AI4Gov, y Cecilia Danesi, investigadora en el Instituto de Estudios Europeos y Derechos Humanos del a Universidad Pontificia de Salamanca. Todos indicadores de seriedad: Europa, investigadores, Salamanca. Lo que en la Retórica Aristóteles llamaba “las pruebas”, pero que eran, como señaló Roland Barthes, más bien “mediadores de confianza”: elementos para inducir a la persuasión.

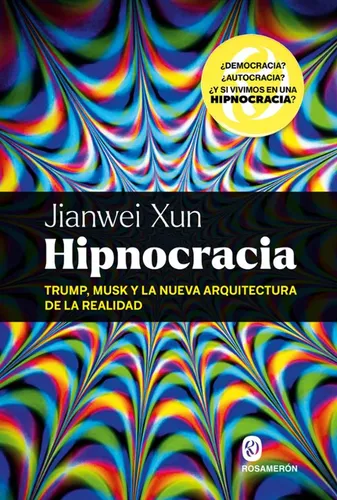

Hipnocracia: Trump, Musk y la nueva arquitectura de la realidad se presentó como un libro del filósofo de Hong Kong Jianwei Xun. Carga en su título un concepto fuerte, presentado como la fase superior (y actual) del fascismo. “Hipnocracia” sería una “dictadura digital que permite modular directamente estados de conciencia” mediante la “manipulación a través de las historias que consumimos, compartimos y creemos”, según le dijo Cecilia Danesi al periodista Raúl Limón, quien lo publicó en un artículo en el diario El País de España el 26 de marzo. El 1 de abril, el periodista argentino Marcelo Longobardi le dijo a Jorge Fontevecchia y la audiencia de Net.TV que Hipnocracia era “el libro del año”. Dos días después, la redactora jefa de la revista italiana L’Espresso, Sabina Minardi, reveló: “El autor de Hipnocracia no existe, es una IA”.

¿Cuál es el cuento que subyace a esta secuencia? ¿Es un cuento sobre la ingenuidad humana? ¿Sobre la superioridad de las máquinas, o, parecido pero diferente, sobre la inferioridad de las personas? ¿Es un cuento sobre el poder de las narrativas? ¿Sobre cómo se mueve el borde de lo verosímil? Sin duda es un meta-cuento, ya que con su existencia prueba su propia tesis, aquella de la manipulación a través de las historias que compartimos.

La noticia de L’Espresso dispara algunas emociones básicas: vergüenza, asombro, risa, expectativa, miedo, en proporciones varias según a quién. Algo del meme de “emosido engañado”. También, una cierta sensación de puesta en abismo, porque es evidente que la segunda noticia, la de que la primera no existe, también había sido, en cierto modo, digitada o preparada. Hay una vieja cita de George Orwell que dice “Periodismo es publicar lo que alguien no quiere que publiques. Todo lo demás es relaciones públicas”.

A las personas en general no nos gusta sentirnos marionetas, y a ningún periodista le gusta sentir que hace relaciones públicas (sobre todo, sin saberlo). Cuando Raúl Limón leyó L’Espresso, escribió una nueva nota contando esta historia, y El País decidió bajar la anterior, que ensalzaba al autor inexistente. Fue una reacción casi refleja que habla de sentirse en falta, de acuerdo a los códigos clásicos del periodismo: mantenerse del lado de la verdad. Longobardi y Fontevecchia hicieron otra cosa: tematizaron la cuestión, un poco riéndose de sí mismos, otro poco aprovechando la oportunidad para aventurarse a pensar en cómo los desarrollos en inteligencia artificial desafían nuestros parámetros. Lo que, en un punto, también podríamos poner del lado de las relaciones públicas: fomentar esa conversación era el objetivo inicial de toda la performance que Hipnocracia implica. Porque si bien Jianwei Xun no existe, el libro es real.

En esta línea, Fontevecchia le preguntó a su público si creía que un texto hecho por una IA podía ser bueno; se lo preguntó también a una figura diseñada por IA y alimentada verbalmente por ChatGPT; y entrevistó largamente a Andrea Colamedici, el principal responsable de crear a Jianwei Xun. El gran prompteador. Colamedici le dijo que de todos los usos que tiene la IA, estamos tomando el más estúpido: el oracular.

Es cierto nomás: todos los modelos de lenguaje tienen en sus cajitas frases como “Pregúntame lo que quieras”. Son más complacientes que los oráculos antiguos, eso sí. Y, quizás, menos confiables.

“La confianza es la moneda del siglo XXI”, decía en 2012 Rachel Botsman, una de las gurús del consumo colaborativo. Pero es una moneda cara. ¿Cómo confiar? ¿En qué confiar? Si ya las imágenes no ofrecen carácter de prueba, ni las voces, ni los videos -todo puede ser un deep fake-, ¿en qué confiamos? ¿Quizás en los sistemas de IA que usamos? ¿Cómo saber en qué confiar, y para qué usos, en un mundo que a cada minuto cambia las reglas?

“Over-reliability” (traducible quizás como “exceso de confianza”) es uno de los nuevos problemas a gestionar que trae la IA junto a su montón de posibilidades. El “costo de la duda”, destacado como una de las tendencia 2025 por Accenture, empieza a hacerle contrapeso a los ahorros de la automatización. Si confío en sistemas que me alivianan las tareas cotidianas y me mejoran la vida, pero a la vez debo medir constantemente los límites de esa confianza, la calibración de ese punto se convierte en la clave de la época, y en un nuevo nicho de oportunidades laborales. Chequear, supervisar, controlar; ya no a trabajadores, como en la fábrica fordista, sino a algoritmos, o a agentes IA, o a la combinación de personas y algoritmos (¿no tiene acaso todo algoritmo algún porcentaje de persona embebido?). Combinaciones de algoritmos y personas que pueden engañarnos intencionalmente o no, o incluso por diseño. El engaño, la estafa, se convierte en el mayor peligro de la época, y el sentimiento de desconfianza -incluso ante la realidad más empírica-, además de aumentar los costos, se nos va quedando pegado. A nadie le gusta sentirse idiota.

Algunas conclusiones provisorias del Hipnogate:

- Las infinitas posibilidades que abren las IA nos igualan en la perplejidad. Personas con y sin conocimientos técnicos, científicos, académicos y periodísticos “caemos” por igual. Emosido baiteado, diría quizás algún militante de la “calle virtual” que son las redes sociales: nuestra atención es manipulada para lograr fines que nos exceden. En el fondo, queremos creer.

- No hay ingeniería más efectiva que la ingeniería social. La IA puede haber intervenido en la escritura del libro Hipnocracia, pero la arquitectura performática y provocativa del engaño es toda del muy humano Colamedici. Recuerda al affaire Sokal, que en los años noventa enfrentó a la academia de las ciencias “duras” con la corriente social y posmoderna. El engaño a plena luz estaba en el uso del lenguaje, algo que las IA manejan cada vez mejor.

- Los estereotipos de pensamiento se están moviendo al este. No es casual que un filósofo provocativo sea inventado con nombre oriental, en la línea del coreano Byung-Chul Han o el hongkongués Yuk Hui, los dos con estudios en Europa. La parodia de Jianwei Xun muestra que la cristalización de este orientalismo europeizado ya está madura para el consumo de masas.

Nos toca trabajar en el arte de calibrar. Calibrar los productos de las IA y las historias que consumimos, compartimos y creemos, pero también nuestras expectativas.